15. ĂlĂŠments de serveurs▲

Dans ce chapitre nous abordons quelques grands principes de fonctionnement des logiciels serveurs. D'abord nous tentons de rÊsumer leurs comportements selon une typologie en quatre modèles gÊnÊriques, puis nous examinons quelques points techniques remarquables de leur architecture logicielle comme la gestion des tâches multiples, des descripteurs multiples, le fonctionnement en arrière-plan (les fameux  daemon ), la gestion des logs...

Enfin nous concluons ce chapitre avec une prÊsentation très synthÊtique du  serveur de serveurs  sous Unix, c'est-à -dire la commande inetd, suivie d'une lecture commentÊe d'un petit code en langage C qui s'inspire de son fonctionnement, pour mieux comprendre sa stratÊgie !

15-1. Type de serveurs▲

L'algorithme intuitif d'un serveur, dÊduit des schÊmas d'utilisation des sockets, pourrait être celui-ci :

- CrÊer une socket, lui affecter une adresse locale avec un numÊro de port connu des clients potentiels ;

- Entrer dans une boucle infinie qui accepte les requĂŞtes des clients, les lit, formule une rĂŠponse et la renvoie au client.

Cette dÊmarche, que nous pourrions qualifier de naïve, ne peut convenir qu'à des applications très simples. ConsidÊrons l'exemple d'un serveur de fichiers fonctionnant sur ce mode. Un client rÊseau qui s'y connecte et tÊlÊcharge pour 10 Go de donnÊes accapare le serveur pendant un temps significativement long, même au regard des bandes passantes modernes. Un deuxième client rÊseau qui attendrait la disponibilitÊ du même serveur pour transfÊrer 1 Ko aurait des raisons de s'impatienter !

15-1-1. Serveurs itĂŠratif et concourant▲

Un serveur itÊratif ( iterative server ) dÊsigne une implÊmentation qui traite une seule requête à la fois.

Un serveur concourant (ÂŤÂ concurrent server ) dĂŠsigne une implĂŠmentation capable de gĂŠrer plusieurs tâches en apparence simultanĂŠes. Attention, cette fonctionnalitĂŠ n'implique pas nĂŠcessairement que ces tâches concourantes doivent toutes s'exĂŠcuter en parallèle... Dans cette première approche purement algorithmique, nous n'abordons pas la mise en Ĺuvre technique, le paragraphe 2 s'y consacrera !

D'un point de vue conceptuel, les serveurs itĂŠratifs sont plus faciles Ă concevoir et Ă programmer que les serveurs concourants, mais le rĂŠsultat n'est pas toujours satisfaisant pour les clients. Au contraire, les serveurs concourants, s'ils sont d'une conception plus savante, sont d'un usage plus agrĂŠable pour les utilisateurs parce que naturellement plus disponibles.

15-1-2. Le choix d'un protocole▲

La pile ARPA nous donne le choix entre TCP et UDP. L'alternative n'est pas triviale. Le protocole d'application peut être complètement bouleversÊ par le choix de l'un ou de l'autre. Avant toute chose il faut se souvenir des caractÊristiques les plus marquantes de l'un et de l'autre.

15-1-2-1. Mode connectĂŠ▲

Le mode connectĂŠ avec TCP est le plus facile Ă programmer, de plus il assure que les donnĂŠes sont transmises, sans perte.

Par contre, il Êtablit un circuit virtuel bidirectionnel dÊdiÊ à chaque client ce qui monopolise une socket, donc un descripteur, et interdit par construction toute possibilitÊ de  broadcast .

L'ĂŠtablissement d'une connexion et sa terminaison entraĂŽne l'ĂŠchange de sept paquets. S'il n'y a que quelques octets Ă ĂŠchanger entre le client et le serveur, cet ĂŠchange est un gaspillage des ressources du rĂŠseau.

Il y a plus prĂŠoccupant. Si la connexion est au repos, c'est-Ă -dire qu'il n'y a plus d'ĂŠchange entre le client et le serveur, rien n'indique Ă celui-ci que le client est toujours lĂ Â ! TCP est silencieux si les deux parties n'ont rien Ă s'ĂŠchanger(182).

Si l'application cliente a ÊtÊ interrompue accidentellement(183), rien n'indique au serveur que cette connexion est terminÊe et il maintient la socket et les buffers associÊs. Que cette opÊration se rÊpète un grand nombre de fois et le serveur ne rÊpondra plus, faute de descripteur disponible, voire de mÊmoire libre au niveau de la couche de transport (allocation au niveau du noyau, en fonction de la mÊmoire totale et au dÊmarrage de la machine) !

15-1-2-2. Mode datagramme▲

Le mode datagramme ou ÂŤÂ non connectĂŠÂ Âť avec UDP hĂŠrite de tous les dĂŠsagrĂŠments de IP, Ă savoir perte, duplication et dĂŠsordre introduit dans l'ordre des datagrammes.

Pourtant malgrÊ ces inconvÊnients UDP reste un protocole qui offre des avantages par rapport à TCP. Avec un seul descripteur de socket un serveur peut traiter un nombre quelconque de clients sans perte de ressources due à de mauvaises dÊconnexions. Le  broadcast  et le  multicast  sont possibles.

Par contre les problèmes de fiabilitÊ du transport doivent être gÊrÊs au niveau de l'application. GÊnÊralement c'est la partie cliente qui est en charge de la rÊÊmission de la requête si aucune rÊponse du serveur ne lui parvient.

La valeur du temps au-delà duquel l'application considère qu'il doit y avoir rÊÊmission est Êvidemment dÊlicate à Êtablir. Elle ne doit pas être figÊe aux caractÊristiques d'un rÊseau local particulier et doit être capable de s'adapter aux conditions changeantes d'un internet.

15-1-3. Quatre modèles de serveurs▲

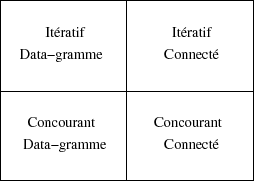

Deux comportements de serveurs et deux protocoles de transport combinÊs induisent quatre modèles de serveurs :

La terminologie  tâche esclave  employÊe dans les algorithmes qui suivent se veut neutre quant au choix technologique retenu pour les implÊmenter. Ce qui importe c'est leur nature concourante avec la  tâche maÎtre  qui les pilote.

Algorithme itĂŠratif - Mode data-gramme

- CrĂŠer une socket, lui attribuer un port connu des clients.

- RÊpÊter :

- Lire une requĂŞte d'un client,

- Formuler la rĂŠponse,

- Envoyer la rĂŠponse, conformĂŠment au protocole d'application.

Critique :

- Cette forme de serveur est la plus simple, elle n'est pas pour autant inutile. Elle est adaptÊe quand il y a un tout petit volume d'information à Êchanger et en tout cas sans temps de calcul pour l'Êlaboration de la rÊponse. Le serveur de date  daytime  ou le serveur de temps  time  en sont d'excellents exemples.

Algorithme ItĂŠratif - Mode connectĂŠÂ :

- CrĂŠer une socket, lui attribuer un port connu des clients.

- Mettre la socket Ă l'ĂŠcoute du rĂŠseau, en mode passif.

- Accepter la connexion entrante, obtenir une socket pour la traiter.

- Entamer le dialogue avec le client, conformĂŠment au protocole de l'application.

- Quand le dialogue est terminĂŠ, fermer la connexion et aller en 3).

Critique :

- Ce type de serveur est peu utilisĂŠ. Son usage pourrait ĂŞtre dĂŠdiĂŠ Ă des relations clients/serveurs mettant en jeu de petits volumes d'informations avec la nĂŠcessitĂŠ d'en assurer Ă coup sĂťr le transport. Le temps d'ĂŠlaboration de la rĂŠponse doit rester court.

- Le temps d'ĂŠtablissement de la connexion n'est pas nĂŠgligeable par rapport au temps de rĂŠponse du serveur, ce qui le rend peu attractif.

Algorithme concourant - Mode datagramme :

MaÎtre :

- CrĂŠer une socket, lui attribuer un port connu des clients.

- RÊpÊter :

- Lire une requĂŞte d'un client,

- CrÊer une tâche esclave pour Êlaborer la rÊponse,

Esclave :

- Recevoir la demande du client ;

- Ălaborer la rĂŠponse ;

- Envoyer la rÊponse au client, conformÊment au protocole de l'application ;

- Terminer la tâche.

Critique :

- Si le temps d'Êlaboration de la rÊponse est rendu indiffÊrent pour cause de crÊation de processus esclave, par contre le coÝt de crÊation de ce processus fils est prohibitif par rapport à son usage : formuler une seule rÊponse et l'envoyer. Cet inconvÊnient l'emporte gÊnÊralement sur l'avantage apportÊ par le  parallÊlisme .

- NĂŠanmoins, dans le cas d'un temps d'ĂŠlaboration de la rĂŠponse long par rapport au temps de crĂŠation du processus esclave, cette solution se justifie.

Algorithme concourant - Mode connectĂŠÂ :

MaÎtre :

- CrÊer une socket, lui attribuer un port connu des clients ;

- Mettre la socket à l'Êcoute du rÊseau, en mode passif ;

- RÊpÊter :

- Accepter la connexion entrante, obtenir une socket pour la traiter,

- CrÊer une tâche esclave pour traiter la rÊponse,

Esclave :

- Recevoir la demande du client ;

- Amorcer le dialogue avec le client, conformÊment au protocole de l'application ;

- Terminer la connexion et la tâche.

Critique :

- C'est le type le plus gÊnÊral de serveur parce qu'il offre les meilleures caractÊristiques de transport et de souplesse d'utilisation pour le client. Il est surdimensionnÊ pour les  petits  services et sa programmation soignÊe n'est pas toujours à la portÊe du programmeur dÊbutant.

15-2. Technologie ĂŠlĂŠmentaire▲

De la partie algorithmique dÊcoulent des questions techniques sur le  comment le faire . Ce paragraphe donne quelques grandes indications très ÊlÊmentaires que le lecteur soucieux d'acquÊrir une vraie compÊtence devra complÊter par les lectures indiquÊes au dernier paragraphe ; la bibliographie du chapitre. Notamment il est nÊcessaire de consulter les ouvrages de W. R. Stevens pour la partie système et David R. Butenhof pour la programmation des threads.

La suite du texte va se consacrer à Êclairer les points suivants :

- Gestion des  tâches esclaves  (paragraphes 2.1, 2.2, 2.3, 2.4)

- Gestion de descripteurs multiples (paragraphes 2.5, 2.6)

- Fonctionnement des processus en arrière-plan ou  daemon  (paragraphe 3)

15-2-1. Gestion des ÂŤÂ tâches esclaves ▲

La gestion des  tâches esclaves  signalÊes dans le paragraphe 1 induit que le programme  serveur  est capable de gÊrer plusieurs actions concourantes, c'est-à -dire qui ont un comportement qui donne l'illusion à l'utilisateur que sa requête est traitÊe dans un dÊlai raisonnable, sans devoir patienter jusqu'à l'achèvement de la requête prÊcÊdente.

C'est typiquement le comportement d'un système d'exploitation qui ordonnance des processus entre eux pour donner à chacun d'eux un peu de la puissance de calcul disponible ( time-sharing ).

La dÊmarche qui parait la plus naturelle pour implÊmenter ces  tâches esclaves  est donc de tirer parti des propriÊtÊs mêmes de la gestion des processus du système d'exploitation.

Sur un système Unix l'usage de processus est une bonne solution dans un premier choix, car ce système dispose de primitives (API) bien rodÊes pour les gÊrer, en particulier fork(), vfork() et rfork().

NĂŠanmoins, comme le paragraphe suivant le rappelle, l'usage de processus fils n'est pas la panacĂŠe, car cette solution comporte des dĂŠsagrĂŠments.

Deux autres voies existent, non toujours valables partout et dans tous les cas de figure. La première passe par l'usage de processus lÊgers ou  threads  (paragraphe 2.3), la deuxième par l'usage du signal SIGIO qui autorise ce que l'on nomme la programmation asynchrone (paragraphe 2.4).

Pour conclure, il faut prÊciser que des tâches esclaves ou concourantes peuvent s'exÊcuter dans un ordre alÊatoire, mais pas nÊcessairement en même temps. Cette dernière caractÊristique est celle des tâches parallèles. Autrement dit, les tâches parallèles sont toutes concourantes, mais l'inverse n'est pas vrai. Concrètement il faut disposer d'une machine avec plusieurs processeurs pour avoir, par exemple, des processus (ou des  threads kernel , si elles sont supportÊes) qui s'exÊcutent vraiment de manière simultanÊe donc sur des processeurs diffÊrents. Sur une architecture monoprocesseur, les tâches ne peuvent être que concourantes !

15-2-2. fork, vfork et rfork▲

Il ne s'agit pas ici de faire un rappel sur la primitive fork() examinĂŠe dans le cadre du cours sur les primitives Unix, mais d'examiner l'incidence de ses propriĂŠtĂŠs sur l'architecture des serveurs.

Le rÊsultat du fork() est la crÊation d'un processus fils qui ne diffère de son père que par les points suivants :

- Le code de retour de fork : 0 pour le fils, le pid du fils pour le père ;

- Le numÊro de processus (pid) ainsi que le numÊro de processus du processus père (ppid) ;

- Les compteurs de temps (utime, stime...) qui sont remis à zÊro ;

- Les verrous (flock) qui ne sont pas transmis

- Les signaux en attente non transmis ĂŠgalement.

Tout le reste est doublonnÊ, notamment la  stack  et surtout la  heap  qui peuvent être très volumineuses et donc rendre cette opÊration pÊnalisante, voire quasi rÊdhibitoire, sur un serveur très chargÊ (des milliers de processus et de connexions rÊseaux).

Si le but du fork dans le processus fils est d'effectuer un exec immÊdiatement, alors il est très intÊressant d'utiliser plutôt le vfork. Celui-ci ne fait que crÊer un processus fils sans copier les donnÊes. En consÊquence, durant le temps de son exÊcution avant le exec le fils partage strictement les mêmes donnÊes que le père (à utiliser avec prÊcaution). Jusqu'à ce que le processus rencontre un exit ou un exec, le processus père reste bloquÊ (le vfork ne retourne pas).

En allant plus loin dans la direction prise par vfork, le rfork(184) autorise la continuation du processus père après le fork, la consÊquence est que deux processus partagent le même espace d'adressage simultanÊment. L'argument d'appel du rfork permet de paramÊtrer ce qui est effectivement partagÊ ou non. RFMEM, le principal d'entre eux, indique au noyau que les deux processus partagent tout l'espace d'adressage.

Si cette dernière primitive est très riche de potentialitÊs(185), elle est Êgalement dÊlicate à manipuler : deux (ou plus) entitÊs logicielles exÊcutant le même code et accÊdant aux mêmes donnÊes sans prÊcaution particulière vont très certainement converger vers de sÊrieux ennuis de fonctionnement si le dÊroulement de leurs opÊrations n'est pas rigoureusement balisÊ.

En effet, le souci principal de ce type de programme multientitÊ est de veiller à ce qu'aucune de ses composantes ne puisse changer les Êtats de sa mÊmoire simultanÊment. Autrement dit, il faut introduire presque obligatoirement un mÊcanisme de sÊmaphore qui permette à l'une des entitÊs logicielles de verrouiller l'accès à telle ou telle ressource mÊmoire pendant le temps nÊcessaire à son usage.

Cette opÊration de  verrouillage  elle-même pose problème, parce que les entitÊs logicielles peuvent s'exÊcuter en parallèle (architecture multiprocesseur) et donc il est indispensable que l'acquisition du sÊmaphore qui protège une ressource commune soit une opÊration atomique, c'est-à -dire qui s'exÊcute en une fois, sans qu'il y ait possibilitÊ que deux (ou plus) entitÊs logicielles tentent avec succès de l'acquÊrir. C'est toute la problÊmatique des mutex(186).

15-2-3. Processus lĂŠgers, les ÂŤÂ threads ▲

Les processus lÊgers ou  threads  sont une idÊe du milieu des annÊes 80. La norme Posix a posÊ les bases de leur dÊveloppement durable en 1995 (Posix 1.c), on parle dans ce cas des pthreads.

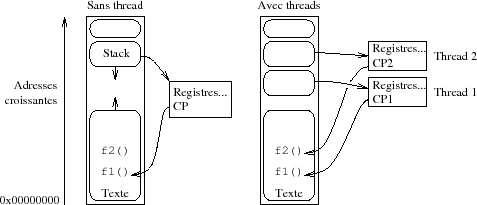

L'idĂŠe fondatrice des threads est de ne pas faire de fork mais plutĂ´t de permettre le partage de l'espace d'adressage Ă autant de contextes d'exĂŠcution du mĂŞme code(187) que l'on souhaite.

Au lieu de crÊer un nouveau processus on crÊe une nouvelle thread, ce qui revient (en gros) à ajouter un nouveau contexte d'exÊcution sur la pile système dans le processus. L'usage de mutex (cf. paragraphe 2.2) est fortement recommandÊ pour sÊrialiser les accès aux  sections critiques  du code.

Sur une machine ayant une architecture monoprocesseur, le premier type de threads est suffisant, mais dès que la machine est construite avec une architecture smp(188) ou cmt(189) (ce qui est de plus en plus le cas avec la banalisation des configurations Ă plusieurs processeurs chacun ĂŠtant lui-mĂŞme composĂŠ de plusieurs cĹurs) l'usage de threads gĂŠrables par le noyau devient beaucoup plus intĂŠressant, car il utilise au mieux les ressources de la machine : un mĂŞme processus pourrait avoir deux threads, une s'exĂŠcutant sur chacun des deux processeurs (ou plus bien entendu, s'il y a plus de processeurs).

Le principe ĂŠtant posĂŠ, on distingue plusieurs familles d'implĂŠmentation.

D'un côtÊ il y a les threads  user land  c'est-à -dire qui sont complètement gÊrÊes par le processus utilisateur et de l'autre les threads  kernel , qui sont gÊrÊes par le noyau. Ces dernières threads sont supportÊes par les constructeurs de machines à architectures parallèles, traditionnellement Sun (Solaris), Ibm (Aix), et Compaq (ex Digital, avec True64) et plus rÊcemment Hewlett-Packard avec la version 11.xx d'HP-UX. Le problème est très complexe et chaque constructeur dÊveloppe ses propres stratÊgies.

Du côtÊ des OS libres le problème a stagnÊ un peu pendant des annÊes, car il monopolise beaucoup de programmeurs de haut niveau, non toujours disponibles pour des tâches au long court... NÊanmoins la famille des BSD (FreeBSD et NetBSD principalement) bÊnÊficie depuis peu d'une gestion opÊrationnelle des threads.

Les threads Linux utilisent rfork qui est simple et très efficace. Cette approche n'est pas satisfaisante, car chaque thread est exÊcutÊe dans un processus diffÊrent (pid diffÊrent donc) ce qui est contraire aux recommandations POSIX, d'une part, et d'autre part ne permet pas d'utiliser les règles de prioritÊ dÊfinies Êgalement par POSIX. Une application avec un grand nombre de threads prend l'avantage sur les autres applications par le fait qu'elle consomme en temps cumulÊ bien plus que les autres processus monothread.

Les threads de FreeBSD sont devenues très efficaces et performantes depuis la version 7 du système, à l'issue d'un travail de longue haleine dont l'historique se trouve sur cette page :

- http://www.freebsd.org/smp/.

Conclusion :

- Les threads user land ne s'exÊcutent que sur un seul processeur quelle que soit l'architecture de la machine qui les supporte. Sur une machine de type smp/cmt il faut que le système d'exploitation supporte les threads kernel pour qu'un même processus puisse avoir des sous-tâches sur tous les processeurs existants.

15-2-4. Programmation asynchrone▲

Les paragraphes qui prĂŠcèdent utilisent un processus ou une thread pour pouvoir effectuer au moins deux tâches simultanĂŠment : ĂŠcouter le rĂŠseau et traiter une (ou plusieurs) requĂŞte(s). Dans le cas d'un serveur peu sollicitĂŠ, il est tout Ă fait envisageable de mettre en Ĺuvre une autre technique appelĂŠe ÂŤÂ programmation asynchrone .

La programmation asynchrone s'appuie sur l'usage du signal, SIGIO (SIGPOLL sur système V), ignorÊ par dÊfaut, qui prÊvient le processus d'une activitÊ sur un descripteur.

La gestion des entrÊes/sorties sur le descripteur en question est alors traitÊe comme une exception, par un  handler  de signaux.

Le signal SIGIO est ignorÊ par dÊfaut, il faut demander explicitement au noyau de le recevoir, à l'aide d'un appel à la primitive fcntl. Une fois activÊ, il n'est pas reçu pour les mêmes raisons selon le protocole employÊ :

- UDPÂ :

- arrivĂŠe d'un paquet pour la socket,

- une erreur ;

- TCPÂ :

- une demande de connexion (attente sur un accept) qui arrive,

- une dĂŠconnexion,

- une demi-dĂŠconnexion (shutdown),

- arrivĂŠe de donnĂŠes sur une socket,

- fin de l'ĂŠmission de donnĂŠes (buffer d'ĂŠmission vide) sur une socket,

- une erreur.

OÚ l'on voit que cette technique, du moins en TCP, ne peut être envisagÊe pour que pour des serveurs peu sollicitÊs. Un trop grand nombre d'interruptions possibles nuit à l'efficacitÊ du système (changements de contexte). De plus la distinction entre les causes du signal est difficile à faire, donc ce signal en TCP est quasi inexploitable.

Conclusion :

- La dÊnomination  programmation asynchrone  basÊe seulement sur l'usage du signal SIGIO (versus SIGPOLL) est abusive. Pour être vraiment asynchrones, ces opÊrations de lecture et d'Êcriture ne devraient pas être assujetties au retour des primitives read ou write(190). Cette technique permet l'Êcriture du code de petits serveurs basÊe sur le protocole UDP (en TCP les causes de rÊception d'un tel signal sont trop nombreuses) sans fork ni thread.

15-2-5. La primitive select▲

Un serveur qui a la charge de gĂŠrer simultanĂŠment plusieurs sockets (serveur multiprotocole par exemple, comme inetd...) se trouve par construction dans une situation oĂš il doit examiner en mĂŞme temps plusieurs descripteurs (il pourrait s'agir aussi de tubes de communication).

Il est absolument dĂŠconseillĂŠ dans cette situation de faire du polling.

Cette activitÊ consisterait à examiner chaque descripteur l'un après l'autre, dans une boucle infinie qui devrait être la plus rapide possible pour être la plus rÊactive possible face aux requêtes entrantes. Sous Unix, cette opÊration entraÎne une consommation exagÊrÊe des ressources CPU, au dÊtriment des autres usagers et services.

La primitive select (4.3 BSD) surveille un ensemble de descripteurs, si aucun n'est actif le processus est endormi et ne consomme aucune ressource CPU. Dès que l'un des descripteurs devient actif (il peut y en avoir plusieurs à la fois) le noyau rÊveille le processus et l'appel de select rend la main à la procÊdure appelante avec suffisamment d'information pour que celle-ci puisse identifier quel(s) descripteur(s) justifie(nt) son rÊveil !

#include <sys/types.h>

#include <sys/time.h>

int select (int maxfd, fd_set *readfs,

fd_set *writefs,

fd_set *exceptfs,

struct timeval *timeout) ;

FD_ZERO(fd_set *fdset) ; /* Tous les bits a zero. */

FD_SET(int fd, fd_set *fdset) ; /* Positionne 'fd' dans 'fdset' */

FD_CLR(int fd, fd_set *fdset) ; /* Retire 'fd' de 'fdset' */

FD_ISSET(int fd, fd_set *fdset) ; /* Teste la prĂŠsence de 'fd' */

struct timeval /* Cf "time.h" */

{

long tv_sec ; /* Nombre de secondes. */

long tv_usec ; /* Nombre de microsecondes. */

} ;Le type fd set est dĂŠcrit dans <sys/types.h>, ainsi que les macros FD XXX.

Le prototype de select est dans <sys/time.h>.

La primitive select examine les masques readfs, writefs et exceptfs et se comporte en fonction de timeout :

- si timeout est une structure existante (pointeur non nul), la primitive retourne immÊdiatement après avoir testÊ les descripteurs. Tous les champs de timeout doivent être à 0 ( polling  dans ce cas) ;

- si timeout est une structure existante (pointeur non nul), et si ses champs sont non nuls, select retourne quand un des descripteurs est prĂŞt, et en tout cas jamais au-delĂ de la valeur prĂŠcisĂŠe par timeout (cf MAXALARM dans <sys/param.h>)Â ;

- si timeout est un pointeur NULL, la primitive est bloquante jusqu'Ă ce qu'un descripteur soit prĂŞt (ou qu'un signal intervienne).

Remarque : select travaille au niveau de la microseconde, ce que ne fait pas sleep (seconde), d'oÚ un usage possible de timer de prÊcision.

- readfs descripteurs Ă surveiller en lecture.

- writefs descripteurs Ă surveiller en ĂŠcriture.

- exceptfs ce champ permet de traiter des ÊvÊnements exceptionnels sur les descripteurs dÊsignÊs. Par exemple :

- donnÊes out-of-band sur une socket ;

- contrĂ´le du statut sur un pseudotty maĂŽtre.

maxfd prend à l'appel la valeur du plus grand descripteur à tester, plus un. Potentiellement un système BSD (4.3 et versions suivantes) permet d'examiner jusqu'à 256 descripteurs.

Ă l'appel, le programme prĂŠcise quels sont les descripteurs Ă surveiller dans readfs, writefs et exceptfs.

Au retour, la primitive prĂŠcise quels sont les descripteurs qui sont actifs dans les champs readfs, writefs et exceptfs. Il convient donc de conserver une copie des valeurs avant l'appel si on veut pouvoir les rĂŠutiliser ultĂŠrieurement. La primitive renvoie -1 en cas d'erreur (Ă tester systĂŠmatiquement)Â ; une cause d'erreur classique est la rĂŠception d'un signal (errno==EINTR).

La macro FD ISSET est utile au retour pour tester quel descripteur est actif et dans quel ensemble.

Le serveur de serveurs inetd est un excellent exemple d'utilisation de la primitive.

15-2-6. La primitive poll▲

La primitive poll (System V) permet la mĂŞme chose que la primitive select, mais avec une approche diffĂŠrente.

#include <poll.h>

int

poll(struct pollfd *fds, unsigned int nfds, int timeout);

struct pollfd {

int fd ; /* Descripteur de fichier */

short events ; /* Evenements attendus */

short revents ; /* Evenements observes */

} ;La primitive retourne le nombre de descripteurs rendus disponibles pour effectuer des opÊrations d'entrÊe/sortie. -1 indique une condition d'erreur. 0 indique l'expiration d'un dÊlai ( time-out ).

- fds est un pointeur sur la base d'un tableau de nfds structures du type struct pollfd.

- Les champs events et revents sont des masques de bits qui paramètrent respectivement les souhaits du programmeur et ce que le noyau retourne. On utilise principalement :

- POLLIN,

- POLLOUT,

- POLLERR,

- POLLHUP,

- POLLIN,

- POLLOUT,

- POLLERR,

- POLLHUP.

- nfds taille du vecteur.

- timeout est un compteur de millisecondes qui prÊcise le comportement de poll :

- le nombre de millisecondes est positif strictement. Quand le temps prĂŠvu est ĂŠcoulĂŠ, la primitive retourne dans le code de l'utilisateur mĂŞme si aucun ĂŠvĂŠnement n'est intervenu,

- le nombre de millisecondes est INFTIM (-1), la primitive est bloquante,

- 0. La primitive retourne immĂŠdiatement.

On s'aperçoit immÊdiatement que la valeur du paramètre de timeout n'est pas compatible ni en forme ni en comportement entre select et poll.

15-3. Fonctionnement des daemons▲

Sous Unix les serveurs sont implĂŠmentĂŠs le plus souvent sous forme de daemons(191). La raison principale est que ce type de processus est le plus adaptĂŠ Ă cette forme de service, comme nous allons l'examiner.

15-3-1. Programmation d'un daemon▲

Les daemons sont des processus ordinaires, mais :

- ils ne sont pas rattachÊs à un terminal particulier (ils sont en  arrière-plan ) ;

- ils s'exÊcutent le plus souvent avec les droits du  superutilisateur , voire, mieux, sous ceux d'un pseudoutilisateur sans mot de passe ni shell dÊfini ;

- ils sont le plus souvent lancÊs au dÊmarrage du système, lors de l'exÊcution des shell-scripts de configuration (par exemple à partir de /etc/rc) ;

- ils ne s'arrêtent en principe jamais (sauf bien sÝr avec le système !).

La conception d'un daemon suit les règles suivantes :

- ExÊcuter un fork, terminer l'exÊcution du père et continuer celle du fils qui est alors adoptÊ par init (traditionnellement c'est le processus N° 1). Le processus fils est alors dÊtachÊ du terminal, ce que l'on peut visualiser avec un ps -auxw (versus ps -edalf sur un système V) en examinant la colonne TT : elle contient ? ? ;

- Appeler la primtive setsid pour que le processus courant devienne  leader  de groupe (il peut y avoir un seul processus dans un groupe) ;

- Changer de rÊpertoire courant, gÊnÊralement la racine (/) ou tout autre rÊpertoire à la convenance de l'application ;

- Modifier le masque de crÊation des fichiers umask = 0 pour que le troisième argument de open ne soit pas biaisÊ par la valeur du umask lorsque cette primitive sert aussi à crÊer des fichiers ;

- Fermer tous les descripteurs devenus inutiles, et en particulier 0, 1 et 2 (entrĂŠe et sorties standards n'ont plus de sens pour un processus dĂŠtachĂŠ d'un terminal).

Le source ci-après est un exemple de programmation de daemon, les appels à la fonction syslog font rÊfÊrence à un autre daemon nommÊ syslogd que nous examinons au paragraphe suivant.

/* $Id: diable.c 92 2009-02-12 17:39:44Z fla $

*

* Diablotin : exemple de dĂŠmon miniature...

*/

#include <stdio.h>

#include <stdlib.h>

#include <unistd.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <syslog.h>

#include <errno.h>

int

main()

{

switch (fork()) {

case -1 : /* erreur du "fork". */

perror("fork") ;

exit (1) ;

case 0 : /* Le futur "demon". */

(void)printf("Je suis infernal, je me transforme en demon !\n") ;

(void)setsid() ; /* Devenir chef de groupe. */

(void)chdir("/") ; /* Repertoire de travail. */

(void)umask(0) ;

(void)close(0) ;

(void)close(1) ;

(void)close(2) ;

openlog("diablotin",LOG_PID|LOG_NDELAY,LOG_USER) ;

syslog(LOG_INFO,"Attention, je suis un vrai 'daemon'...\n") ;

(void)sleep(1) ;

(void)syslog(LOG_INFO,"Je me tue !\n") ;

closelog() ;

exit(EX_OK) ;

default :

exit(EX_OK) ;

}

}15-3-2. Daemon syslogd▲

Du fait de leur fonctionnement dÊtachÊ d'un terminal, les daemons ne peuvent plus dÊlivrer directement de message par les canaux habituels (perror...). Pour pallier cette dÊficience, un daemon est spÊcialisÊ dans l'Êcoute des autres daemons (Êcoute passive :), il s'agit de syslogd(192).

Pour dialoguer avec ce daemon un programme doit utiliser les fonctionnalitÊs que le lecteur trouvera très bien dÊcrites dans  man syslog , sinon le paragraphe 3.4 en donne un aperçu rapide.

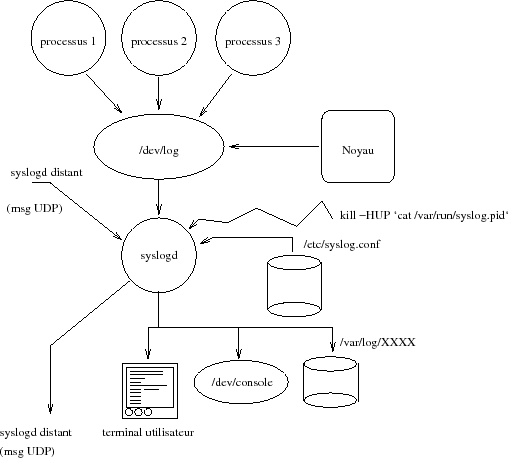

La figure XIV.3 suivante schĂŠmatise le circuit de l'information dans le cas d'une utilisation de syslogd.

Le fichier /etc/syslog.conf est le fichier standard de configuration du daemon syslogd. Il est constituÊ de lignes de deux champs : un dÊclencheur (selector) et une action. Entre ces deux champs un nombre quelconque de tabulations.

Si les conditions du dÊclencheur sont remplies, l'action est exÊcutÊe, plus prÊcisÊment :

le dÊclencheur est un filtre qui associe un type de daemon avec un niveau de message. Par exemple mail.debug signifie les messages de niveau DEBUG pour le système de routage du courrier ;

les mots-clefs possibles pour le type de daemon sont auth, authpriv, cron, daemon, kern, lpr, mail, news, syslog, user, uucp, et local0 à local7. Une Êtoile (*) à la place, signifie n'importe quel mot-clef ;

le niveau de message est l'un des mots-clefs suivants : emerg, alert, crit, err, warning, notice, et debug. Une Êtoile (*) signifie n'importe lequel. Un point (.) sÊpare les deux parties du filtre, comme dans mail.debug.

Dans les syslog plus ĂŠvoluĂŠs, l'administrateur a la possibilitĂŠ de dĂŠrouter tous les messages contenant un nom de programme (Â !nom du prog) ou un nom de machine (+nom de machine).

L'action est soit :

- un fichier dÊsignÊ par un chemin absolu, comme /var/log/syslog ;

- une liste de logins d'utilisateurs, comme root, fla... ;

- un nom de machine distante (@machine.domaine.fr)Â ;

- tous les utilisateurs connectĂŠs avec une ĂŠtoile.

15-3-3. Fichier syslog.conf▲

Exemple de fichier /etc/syslog.conf :

*.err;kern.debug;auth.notice;mail.crit /dev/console

*.notice;kern.debug;lpr,auth.info;mail.crit /var/log/messages

mail.info /var/log/maillog

lpr.info /var/log/lpd-errs

cron.* /var/cron/log

*.err root

*.notice;auth.debug root

*.alert root

*.emerg *

*.info |/usr/local/bin/traitinfo

!diablotin

*.* /var/log/diablotin.logRÊsultat de l'exÊcution de diablotin sur la machine glups, et dans le fichier /var/log/diablotin.log :

...

Jan 27 18:52:02 glups diablotin[20254]: Attention, je suis un vrai 'daemon'...

Jan 27 18:52:03 glups diablotin[20254]: Je me tue !15-3-4. Fonctions syslog▲

Les prototypes et arguments des fonctions :

#include <syslog.h>

void openlog(const char *ident, int logopt, int facility) ;

void syslog(int priority, const char *message, ...) ;

void closelog(void) ;Comme dans l'exemple de  diablotin , un programme commence par dÊclarer son intention d'utiliser le système de log en faisant appel à la fonction openlog :

- logopt donne la possibilitÊ de prÊciser oÚ le message est envoyÊ et dans quelle condition ;

- facility est l'Êtiquette par dÊfaut des futurs messages envoyÊs par syslog ;

- logopt description

- LOG CONS ĂŠcriture sur /dev/console,

- LOG NDELAY ouverture immĂŠdiate de la connexion avec syslogd,

- LOG PERROR ĂŠcriture d'un double du message sur stderr,

- LOG PID Identifier chaque message avec le pid ;

- facility description

- LOG AUTH services d'authentification,

- LOG AUTHPRIV idem ci-dessus,

- LOG CRON le daemon qui gère les procÊdures batch,

- LOG DAEMON tous les daemons du système, comme gated,

- LOG KERN messages du noyau,

- LOG LPR messages du gestionnaire d'imprimante,

- LOG MAIL messages du gestionnaire de courrier,

- LOG NEWS messages du gestionnaire de  news ,

- LOG SYSLOG messages du daemon syslogd lui-mĂŞme,

- LOG USER messages des processus utilisateur (defaut),

- LOG UUCP messages du système de transfert de fichiers,

- LOG LOCAL0 rĂŠservĂŠ pour un usage local.

Puis chaque appel à la fonction syslog est composÊ d'un message (gÊnÊrÊ par l'application) et d'un code de prioritÊ, composÊ d'un niveau d'urgence prÊcisÊ par le tableau ci-dessous (niveaux dÊcroissants) et d'une Êtiquette optionnelle, prise dans le tableau ci-dessus ; elle prime alors sur celle prÊcisÊe lors du openlog.

- priority description

- LOG EMERG une condition de  panic system ,

- LOG ALERT intervention immĂŠdiate requise,

- LOG CRIT problèmes de matÊriels,

- LOG ERR erreurs,

- LOG WARNING messages d'avertissement,

- LOG NOTICE messages qui ne sont pas des erreurs,

- LOG INFO informations sans consĂŠquence,

- LOG DEBUG messages pour le dĂŠbogage,

- LOG EMERG une condition de  panic system ,

- LOG ALERT intervention immĂŠdiate requise,

- LOG CRIT problèmes de matÊriel,

- LOG ERR erreurs,

- LOG WARNING messages d'avertissement,

- LOG NOTICE messages qui ne sont pas des erreurs,

- LOG INFO informations sans consĂŠquence,

- LOG DEBUG messages pour le dĂŠbogage.

Enfin le closelog matÊrialise la fin d'utilisation de ce système dans le code.

15-4. Exemple de ÂŤÂ daemon  inetd▲

Dans cette partie nous allons Êtudier un serveur de serveurs nommÊ inetd qui est un très bel exemple pour conclure ce chapitre.

Ce chapitre pourra se prolonger par la lecture du code source C d'inetd.

15-4-1. PrĂŠsentation de inetd▲

Sous Unix, on peut imaginer facilement que chacun des services rĂŠseau offerts soient programmĂŠs comme un daemon, avec une ou plusieurs sockets, chacun surveillant son ou ses ports de communication.

Un tel fonctionnement existe, gÊnÊralement repÊrÊ par le vocabulaire  stand alone . Avec cette stratÊgie, chaque service comme  ftp ,  rlogin , ou encore  telnet  fait l'objet d'un processus daemon ( daemon ).

Avant la version 4.3 de BSD, c'est comme cela que tous les services fonctionnaient.

Le problème est que pour faire fonctionner les services de base du rÊseau on devait maintenir en mÊmoire (primaire en  ram  ou secondaire sur la zone de  swap ) un grand nombre de processus souvent complètement inutiles à un instant donnÊ, simplement au cas oÚ...

L'inconvÊnient de cette stratÊgie est la consommation importante de ressources surtout avec le nombre croissant des services rÊseau  de base .

De plus, on peut remarquer que lancÊs au dÊmarrage de la machine, tous ces processus effectuent des opÊrations similaires (cf. 3), seuls diffèrent les traitements propres aux serveurs eux-mêmes c'est-à -dire ceux qui relèvent du protocole de l'application.

La version 4.3 de BSD a apportÊ une simplification en introduisant une nouvelle notion, celle de serveur de serveurs :  The Internet superserver - inetd . C'est un daemon que peuvent utiliser tous les serveurs TCP/UDP.

Inetd fournit essentiellement deux services principaux :

- Il permet à un seul processus (celui d'inetd) d'attendre de multiples demandes de connexions au lieu d'avoir un processus par type de connexion. Cette stratÊgie rÊduit d'autant le nombre de processus ;

- Il simplifie l'Êcriture des serveurs eux-mêmes, puisqu'il gère toute la prise en charge de la connexion. Les serveurs lisent les requêtes sur leur entrÊe standard et Êcrivent la rÊponse sur leur sortie standard.

Inetd est un serveur parallèle en mode connectÊ ou datagramme. De plus il combine des caractÊristiques particulières, puisqu'il est Êgalement multiprotocole et multiservice. Un même service peut y être enregistrÊ et accessible en udp comme en tcp. Bien sÝr cela sous-entend que le programmeur de ce service a prÊvu ce fonctionnement.

Le prix Ă payer pour une telle souplesse est ĂŠlevĂŠ, inetd invoque fork puis exec pour pratiquement tous les services qu'il offre (cf. lecture de code).

Sur les Unix à architecture Berkeley, inetd est invoquÊ au dÊmarrage de la machine, dans les scripts de lancement, /etc/rc par exemple. Dès le dÊbut de son exÊcution il se transforme en daemon (cf. paragraphe IV.5.3) et lit un fichier de configuration gÊnÊralement nommÊ /etc/inetd.conf. Ce fichier est en ASCII, il est lisible normalement par tous, cependant, sur certains sites et pour des raisons de sÊcuritÊ, il peut ne pas l'être.

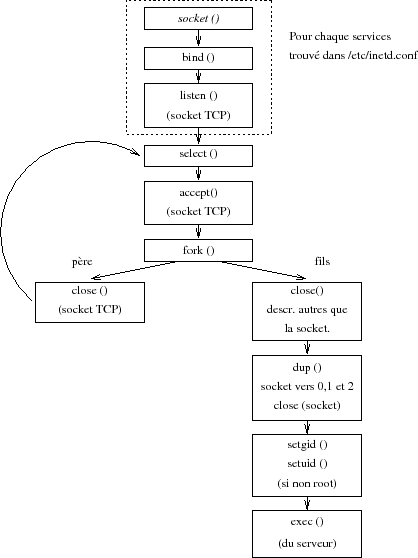

La figure XIV.04 montre l'architecture gÊnÊrale (très simplifiÊe) de fonctionnement.

Le fichier /etc/inetd.conf est organisÊ de la manière suivante :

- un # en dÊbut de ligne indique un commentaire, comme pour un shellscript ;

- les lignes vides ne sont pas prises en compte ;

- les lignes bien formĂŠes sont constituĂŠes de sept champs. Chaque ligne bien formĂŠe dĂŠcrit un serveur.

Description des champs :

- Le nom du service, qui doit Êgalement se trouver dans le fichier /etc/services. C'est grâce à lui que inetd connait le numÊro de port à employer ;

- Le type de socket, connectĂŠe (stream) ou non (dgram)Â :

- Le protocole qui doit être tcp ou udp et doit en tout cas se trouver dans le fichier /etc/protocols. Ce dernier fichier donne une correspondance numÊrique aux diffÊrents protocoles ;

- wait ou nowait suivant que le serveur est itÊratif ou parallèle ;

- Le nom du propriÊtaire (pour les droits à l'exÊcution). Le plus souvent c'est root, mais ce n'est pas une règle gÊnÊrale ;

- Le chemin absolu pour dÊsigner l'exÊcutable du serveur ;

- Les arguments transmis Ă cet exĂŠcutable lors du exec, il y en a 20 au maximum dans les implĂŠmentations Berkeley de inetd (certaines rĂŠĂŠcritures, comme celle d'HP, limitent ce nombre).

15-5. Exemple de code serveur▲

L'exemple qui suit est le code en langage C d'un serveur d'Êcho multiprotocole, c'est-à -dire qui fonctionne avec TCP et UDP simultanÊment sur un même numÊro de port pour les deux protocoles. La contrainte est que l'usage du serveur pour l'un des protocoles n'empêche pas l'accès au serveur pour l'autre protocole.

Ce serveur offre Êgalement le choix de travailler en mode itÊratif ou en mode parallèle. Cette alternative est pilotÊe à partir de la ligne de commande, donc au lancement du serveur (option -n ou -w).

Il est intĂŠressant de remarquer que le cĹur du serveur est construit autour de l'usage de la primitive select pour gĂŠrer l'ĂŠcoute sur des sockets multiples, ici au nombre de deux.

D'un point de vue plus gĂŠnĂŠral ce serveur reprend l'architecture globale du serveur de serveur inetd mais le simplifiant Ă l'extrĂŞme, c'est-Ă -dire sans gestion du fichier de configuration, et sans gestion des limites.

15-5-1. Guide de lecture du source serv2prot.c▲

Le source de cet exemple se trouve Ă l'annexe A.

Le programme 'serv2prot' le lance avec les options suivantes :

- -p numÊro du port ;

- -n mode concourant ;

- -w mode itĂŠratif.

- la fonction 'main' (ligne 64 à 178) contient la structure principale du programme ;

- Ligne 77 boucle de lecture des arguments de la ligne de commande. L'option -p a besoin d'un argument (le # de port) dont la lecture est effectuÊe ligne 80 (usage de la fonction atoi pour transformer la chaÎne de caractères en entier) ;

- Ligne 102 ouverture d'une socket UDP utilisant le port nport lu sur la ligne de commande ;

- Ligne 103 mĂŞme chose que ligne 102, mais avec une socket TCPÂ ;

- Ligne 104 c'est le majorant de sudp et stcp (pour select)Â ;

- Ligne 106 mise Ă zĂŠro de tous les bits de la variable lect (fd set)Â ;

- Ligne 107 ajout du descripteur udp ;

- Ligne 108 ajout du description tcp ;

- Ligne 110 mise en place de la prise en compte des signaux de type SIGCHLD. C'est la fonction PasDeZombi qui est appelÊe ;

- Ligne 111 mise en place de la prise en compte du signal de fin, ici un SIGHUP. Appel de la fonction FinCanonique dans ce cas ;

- Ligne 113 entrÊe de la boucle principale et infinie du serveur ;

- Ligne 114 recopie dans alire des descripteurs à surveiller en lecture ;

- Ligne 116 appel de la primitive select, sans time-out, donc bloquante indĂŠfiniment (c'est-Ă -dire jusqu'Ă l'arrivĂŠe d'une demande de cnx)Â ;

- Ligne 118 si on arrive Ă cette ligne c'est qu'un signal a interrompu la primitive. Le rĂŠsultat du test est VRAI si la primitive a ĂŠtĂŠ interrompue par un signal (par exemple SIGCHLD), le 'continue' permet de retourner Ă l'ĂŠvaluation de la condition de sortie de boucle immĂŠdiatement. Sinon il s'agit d'une erreur non contournable, affichage d'un message et sortie.

- Ligne 124 select a renvoyÊ le nombre de descripteurs qui justifient son retour en  user land . Ce nombre est un ou deux au maximum (seulement deux sockets à surveiller). On boucle jusqu'à Êpuisement du nombre de descripteurs à examiner ;

- Ligne 125 FD ISSET permet de tester si la socket stcp est active. Si oui alors on passe Ă la ligne 127Â ;

- Ligne 127 appel de accept pour la socket tcp. Il faut noter qu'on ne tient pas compte de l'adresse du client rÊseau (deuxième et troisième arguments). sock contient le descripteur de la socket vers le client.

- Ligne 133 idem que ligne 125, mais pour la socket UDPÂ ;

- Ligne 138 usage de la primitive getpeername pour obtenir l'adresse de la socket du client (adresse IP + numĂŠro de port)Â ;

- Ligne 142 usage des fonctions inet ntoa et ntohs pour afficher l'adresse IP et le port du client qui se connecte ;

- Ligne 144 il s'agit d'une ĂŠtiquette, point d'entrĂŠe du goto qui se situe ligne 148Â ;

- Ligne 145 on tente de lancer le service demandÊ, à exÊcuter dans un processus fils ;

- Ligne 147 en cas d'erreur, si le fork a ÊtÊ interrompu par un signal, par exemple eaSIGCHLD, on effectue un saut inconditionnel à l'Êtiquette retry signalÊe ligne 144. Sinon c'est une vraie erreur à traiter ;

- Ligne 151 il s'agit du code exĂŠcutĂŠ dans le processus fils. intcp==VRAI s'il s'agit de la socket TCP. Fermeture des sockets devenues inutiles (c'est sock qui est utile)Â ;

- Ligne 155 invocation la fonction qui gère l'Êcho en TCP ;

- Ligne 158 fermeture de la socket TCP inutile. La socket UDP est indispensable ;

- Ligne 159 invocation de la fonction qui gère l'Êcho en UDP ;

- Ligne 161 sortie du code pour les processus fils ;

- Ligne 162 il s'agit du code exÊcutÊ dans le processus père. Si le mode de fonctionnement est itÊratif, la socket en question (TCP vs UDP) doit être retirÊe des descripteurs à surveiller. Elle y sera remise lorsque le processus fils qui traite la session en cours sera terminÊ (cf. fonction PasDeZombi ligne 184) ;

- Ligne 165 si on vient de traiter la socket TCP, on fait le mÊnage avant la prochaine boucle : fermeture de sock devenu inutile, retrait de stcp de alire et conservation d'une trace du pid ;

- Ligne 175 on dÊcrÊmente le nombre de descripteurs à examiner ;

- Ligne 177 fin de la boucle principale commencĂŠe ligne 124Â ;

- Ligne 171 conservation du pid du fils UDP et suppression de sudp de alire. La fonction PasDeZombi est le handler pour les signaux de type SIGCHLD, envoyÊs par le noyau au processus père dès que l'un de ses fils fait exit ;

- Ligne 194 usage de la primitive wait3 qui permet de faire une attente non bloquante (c'est justifiÊ dans la mesure oÚ on a reçu un SIGCHLD) de la mort d'un fils. Chaque appel renvoie le pid d'un processus fils mort, s'il n'y a plus de processus fils mort à examiner le retour est nÊgatif. C'est la condition de sortie de boucle ;

- Ligne 195 si on entre dans ce test, la variable pid contient le pid du fils terminÊ et le mode de fonctionnement est itÊratif ;

- Ligne 197 pour la socket TCP on remet stcp dans les descripteurs à surveiller ;

- Ligne 202 pour la socket UDP on remet sudp dans les descripteurs à surveiller ;

- Ligne 207 certains OS ont besoin que l'on repositionne le handler de signaux Ă chaque rĂŠception du signal. Ce n'est pas le cas des BSDÂ ;

- Ligne 215 FinCanonique est appelÊe sur rÊception du signal de fin SIGHUP. C'est la sortie inconditionnelle du programme ;

- Les fonctions OuvrirSocketUDP et OuvrirSocketTCP sont une reformulation de ce qui a dÊjà ÊtÊ examinÊ prÊcÊdemment ;

- Les fonctions TraiterTCP et TraiterUDP ne prĂŠsentent pas de difficultĂŠ de lecture.

15-6. Bibliographie▲

Pour la partie architecture/configuration des serveurs :

- W. Richard Stevens -  Unix Network Programming  - Prentice All - 1990

- W. Richard Stevens -  Unix Network Programming  - Volume 1 & 2 - Second edition - Prentice All - 1998

- W. Richard Stevens -  Advanced Programming in the UNIX Environment  - Addison-Wesley - 1992

- W. Richard Stevens - Bill Fenner - Andrew M. Rudoff -  Unix Network Programming  - Third edition, volume 1 - Prentice All - 2004

- Douglas E. Comer - David L. Stevens - ÂŤÂ Internetworking with TCP/IP - Volume IIIÂ Âť (BSD Socket version) - Prentice All - 1993

- Stephen A. Rago -  Unix System V Network Programming  - Addison-Wesley - 1993

- Man Unix de inetd, syslog, syslogd et syslog.conf.

Pour la programmation des threads :

- David R. Butenhof -  Programming with POSIX Threads  - Addison-Wesley - 1997

- Bradford Nichols, Dirsk Buttlar & Jacqueline Proulx Farell -  Pthreads programming  - O'Reilly & Associates, Inc. - 1996

Et pour aller plus loin dans la comprÊhension des mÊcanismes internes :

- McKusick, Bostik, Karels, Quaterman -  The Design and implementation of the 4.4 BSD Operating System  - Addison Wesley - 1996

- Jim Mauro, Richard McDougall -  Solaris Internals  - Sun Microsystems Press - 2001

- Uresh Vahalia -  Unix Internals, the new frontiers  - Prentice Hall - 1996